Россия продолжает дискредитировать украинских военных. В последнее время эта кампания не столько активизировалась, сколько видоизменилась: к увеличению количества российских инсценировок добавились фотофейки и дипфейки. Рассказываем о последних тенденциях, как дискредитируют украинскую армию и как распознать фальсификации.

Такое внимание к украинской армии со стороны российской пропаганды неудивительно — по опросам, армия пользуется большим доверием в обществе. Россияне продолжают попытки дискредитации украинской армии различными способами с 2014 года. С началом полномасштабного вторжения их количество увеличилось, а тактика каждый раз меняется.

В сети можно встретить различные примеры российских вбросов: «кривые» инсценировки, плохой фотошоп, фейковые репортажи и сайты, которые выдают за публикации западных СМИ. Параллельно с этим российская пропаганда осваивает искусственный интеллект и подделывает новости, где военных выставляют главными виновниками в любой ситуации. Да, подделки все еще не идеальны, но местами имеют лучшее качество.

Далее — о последних российских подделках и как с ними бороться.

Шедевры российского кинематографа

Российская пропаганда регулярно создает постановочные видео. Например, россияне опубликовали ролик, где якобы мобилизованный бьет военного ТЦК, которого также отправили на передовую. Или рассказывают, что якобы военный избил полицейского в Харькове.

Инсценированные видео

Для некоторых видео россияне используют одних и тех же «актеров». Например, опубликовали ролик, где якобы военные ТЦК опускают женщину в колодец. Причиной такого «наказания» якобы стало нападение женщины на военного — мол, она защищала своего мужа. Через некоторое время появилось видео, где «украинские военные» расстреливают женщину. По «сюжету» она продала бойцам ВСУ некачественный алкоголь, из-за чего те умерли. Женщины между собой на этих двух видео похожи: у них одинаковый голос и похожая одежда.

Инсценированные видео с одной и той же «актрисой»

Как распознать постановку?

- «Феноменальная» актерская игра (иногда одних и тех же актеров).

- Их преимущественно выдает акцент. Хотя россияне улучшают украинский, но он далек от идеального.

- Ненормативная одежда, а опознавательные знаки ложные или отсутствуют.

- Не хватает важных деталей: адресов, имен, дат и т. д., что странно, потому что по «легенде» эти видео снимают для огласки.

- Видео распространяют сомнительные ресурсы. Россияне используют тезисы «получили видео с телефона пленного/погибшего бойца ВСУ» или «увидели в украинском тиктоке». Для последнего сами россияне создают аккаунты.

- Странные ракурсы съемки: во время съемки самые важные детали (лица людей или моменты выстрелов) не попадают в кадр.

Фотошоп и российская дезинформация

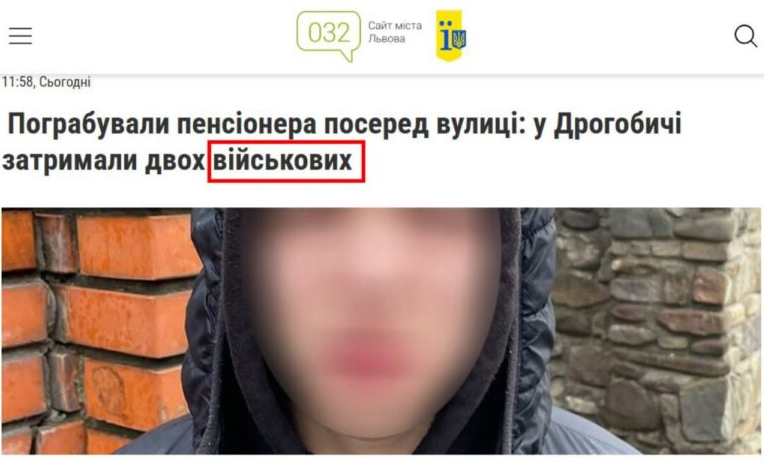

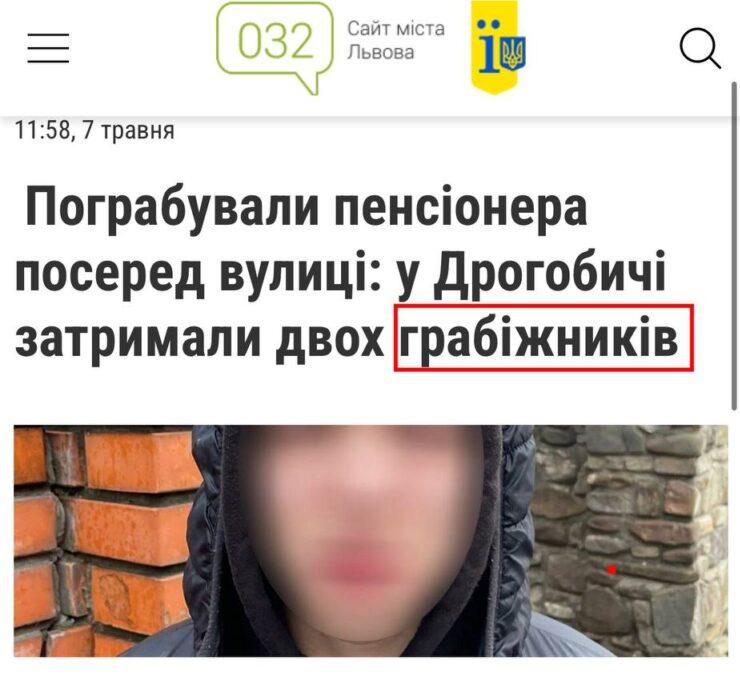

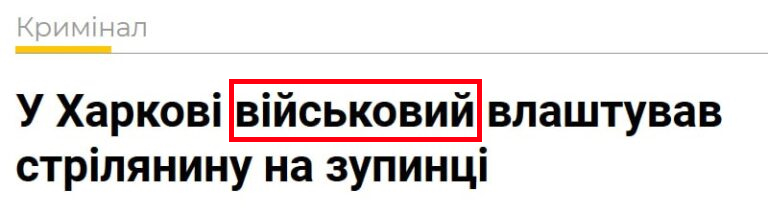

Помимо видеопостанов, российская пропаганда также распространяет отредактированные скриншоты, на которых приписывает украинским защитникам грабеж, убийство или любые другие преступления. Для их создания в настоящие статьи украинских СМИ о преступлениях добавляют текст о военных. Однако в оригинале никаких упоминаний о причастности злоумышленников к армии нет.

Сверху — фейковая новость. Снизу — оригинальная статья

Сверху — фейковая новость. Внизу — оригинальная статья

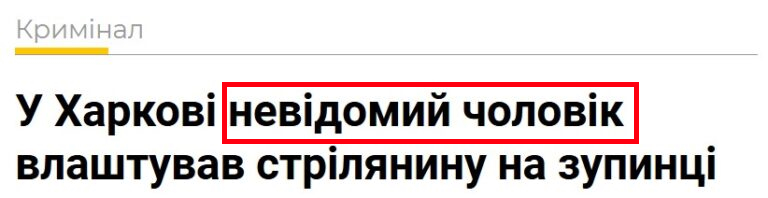

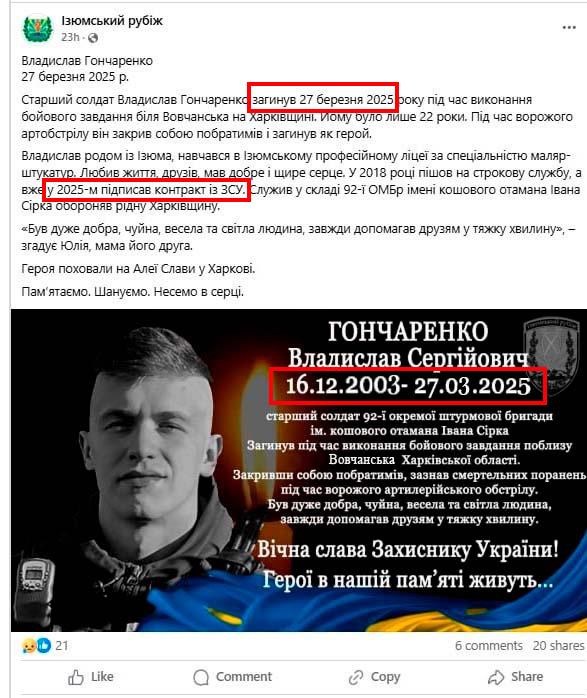

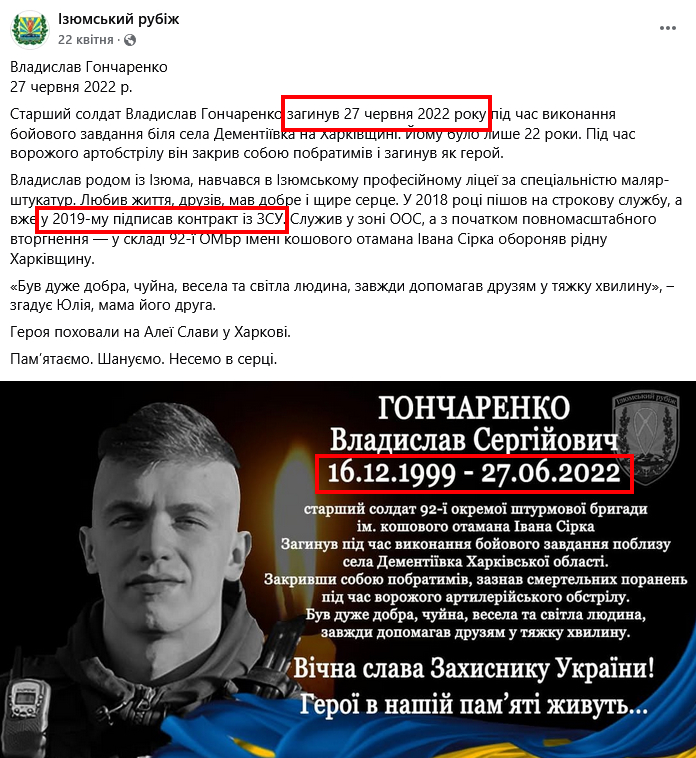

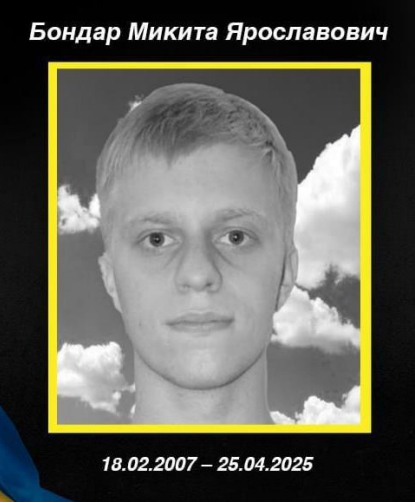

Отдельное направление фотоподделок — отредактированные некрологи. Особенно россияне делают акцент на дискредитации «Контракта 18-24». Россияне лгут о смерти военных, которые подписали контракт, еще до момента окончания их обучения.

Подобные фейки россияне распространили о смерти Александра Самойловича и Владислава Гончаренко, которые якобы согласились на «Контракт 18-24». Эти военные, к сожалению, действительно погибли, но не имели отношения к программе. Сообщения об их смерти отредактировали.

Сверху — поддельный скриншот. Снизу — скриншот оригинального сообщения

Еще один пример: пропагандисты для создания фейкового некролога придумали имя 18-летнего военного (Никита Бондарь) и использовали фото призера олимпиад по информатике.

С помощью сервиса распознания лиц PimEyes мы установили, что на фото не Никита Бондарь, а Денис Терещенко. Парень неоднократно принимал участие в олимпиадах по информатике. Фото, которое использовали для фейка о гибели, сделали в сентябре 2024 года. Тогда парень завоевал серебряную медаль на Международной олимпиаде по информатике в Александрии, Египет. В сентябре 2024 года Терещенко учился в 11 классе, поэтому его обучение должно было продлиться до мая 2025 года. То есть он не мог вступить в армию, ведь учился в школе.

Вверху — фото из фейкового поста; внизу — фото Дениса Терещенко

Как распознать фотофейки?

- Найти и просмотреть оригинальные публикации о событии (новость в СМИ или пост в соцсетях).

- Дополнительно проверить информацию в качественных всеукраинских или региональных СМИ.

- Провести обратный поиск фото, чтобы найти оригинальную фотографию и информацию о ней.

Искусственный интеллект на службе российской пропаганды

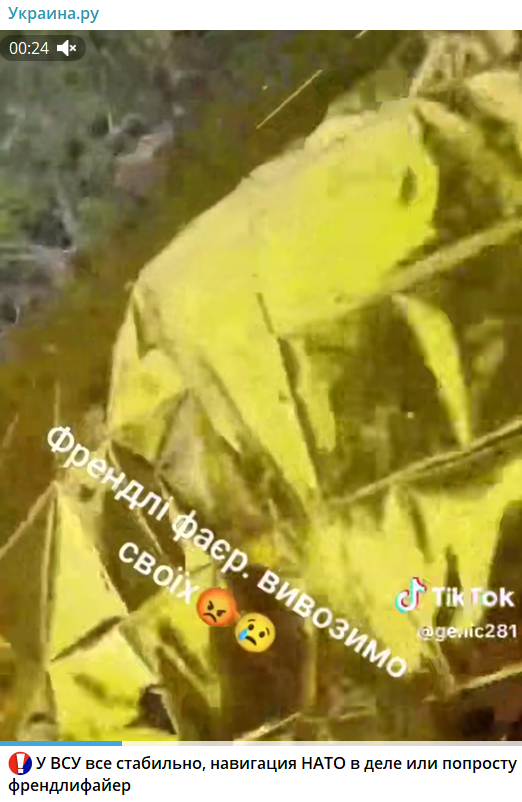

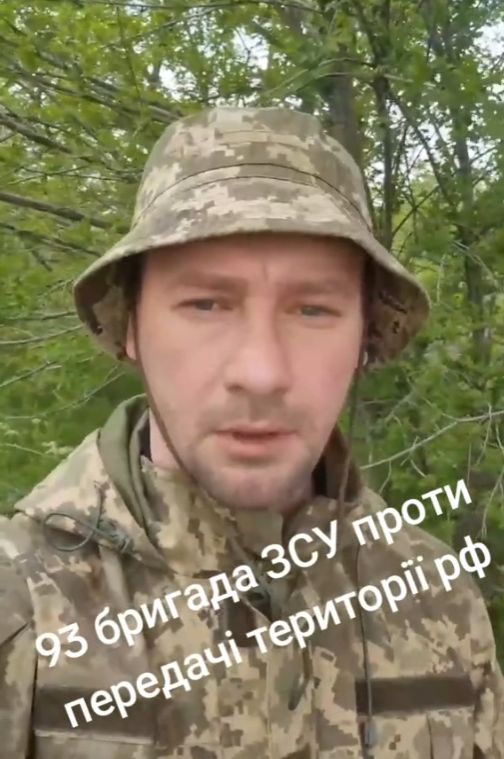

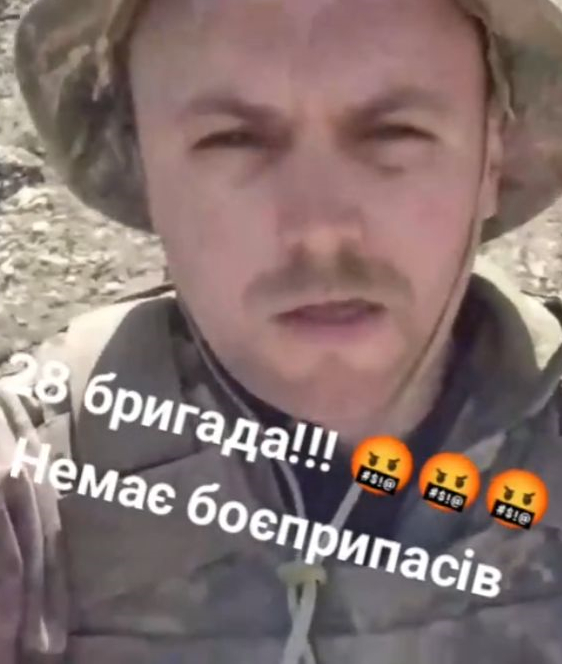

Также для создания фейковых видео или фото российская пропаганда использует искусственный интеллект. Например, россияне распространяли видео, где якобы украинский военный рассказывал о «дружеском огне» из-за отсутствия координации между военными. Или как военный якобы говорит о походе в СОЧ из-за потерь и плохого руководства. Для их создания россияне подменяли лица и генерировали звуковые дорожки.

Фейки, где использовали искусственный интеллект

Также есть примеры, когда один и тот же «военный» служит в разных подразделениях и имеет разный голос.

Видео, где использовали ИИ

С помощью ИИ создают не только фейковые видео о военных, но и фото. В сети неоднократно распространяли сгенерированные фотографии, где призывали помолиться за военных или поздравить их с праздником. Но не весь ИИ-контент такой «невинный» — впоследствии в постах могут злоупотреблять доверием к военным и вбрасывать «зраду».

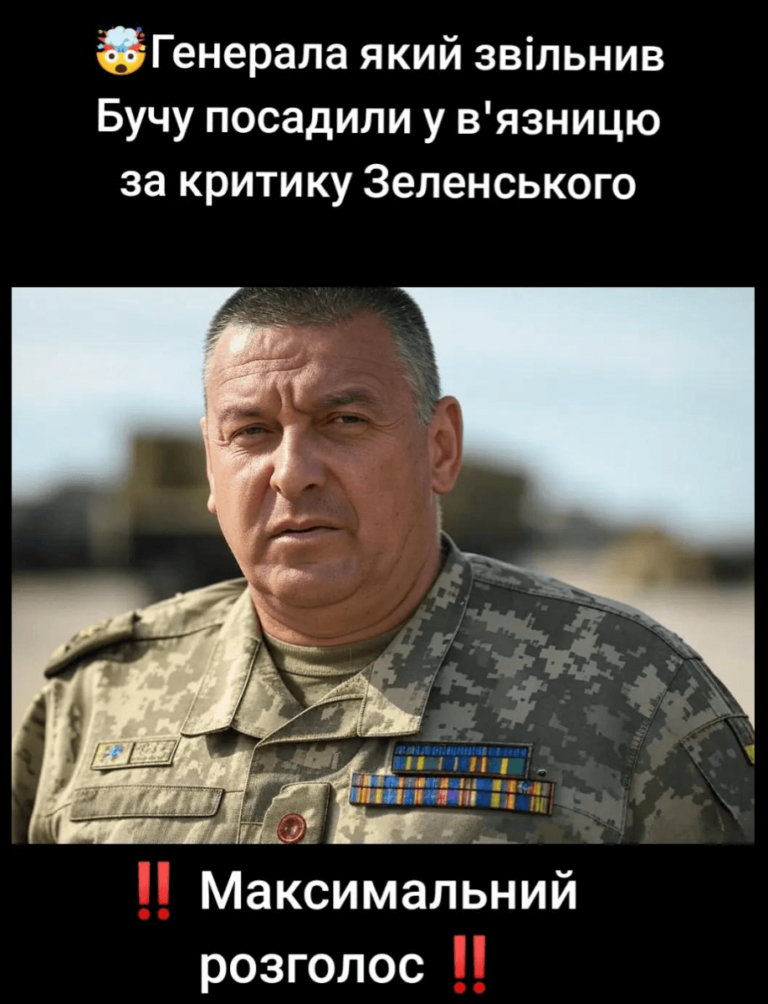

Например, в сети распространяли фото якобы генерала, который «освободил Бучу», а затем получил тюремный срок за критику Владимира Зеленского. Хотя на самом деле изображение военного сгенерировали с помощью ИИ.

Фото, сгенерированное ИИ

Как распознать дипфейки?

- Расхождение в жестикуляции: лицо выглядит неестественно, движения головой обрывистые, а мимика не совпадает со словами.

- Визуальные дефекты: «глянцевая» кожа, лишние пальцы, размытый фон или его элементы выглядят странно и не соответствуют контексту.

- «Идеальность фото»: фотография имеет как бы студийное освещение, идеальную симметрию, позу и угол зрения. Кожа имеет нереалистичную однородную и четкую текстуру, лишенную человеческих недостатков.

- Неточности в одежде, опознавательных знаках и т. п.

- Нелогичное расположение объектов (на двух фотографиях на одну тему здание выглядит по-разному), нереалистичное освещение или нарушение физических законов.

- Звуковые неточности или ошибки (отсутствие звуков на фоне, их неестественность или несоответствие).

- Некачественный источник, распространяющий фейк (характерно для многих фейков). Можно воспользоваться инструментами для выявления ИИ (Hive Moderation, Deepware Scanner или DeepFake-o-meter). Да, они не дают 100% результата, но в комплексе с другими методами помогут обнаружить фейк.

Российская пропаганда неустанно совершенствует свои методы дискредитации украинских военных, комбинируя старые инструменты, такие как постановочные видео и фотошоп, с современными технологиями, в частности искусственным интеллектом. От грубых инсценировок до дипфейков — каждое из этих средств направлено на подрыв доверия к Силам обороны, которые остаются ключевой опорой общества. Однако многочисленные признаки фальсификаций — от актерских промахов до технических недостатков ИИ — позволяют разоблачать эти фейки. Если вы заметили сомнительную информацию в сети, воспользуйтесь нашими советами по проверке.

Фото: depositphotos.com/ua

Предостережение

Автор не является сотрудником, не консультирует, не владеет акциями и не получает финансирования ни от одной компании или организации, которая имела бы пользу от этой статьи, а также никак с ними не связан.