Росія продовжує дискредитувати українських військових. Останнім часом ця кампанія не так пожвавилася, як видозмінилася: до збільшення кількості російських інсценувань додалися фотофейки та діпфейки. Розповідаємо про останні тенденції, як дискредитують українське військо та як розпізнати фальсифікації.

Така увага до українського війська зі сторони російської пропаганди не дивна — за опитуваннями армія має велику довіру у суспільстві. Росіяни продовжують спроби дискредитації української армії у різний спосіб із 2014 року. З початком повномасштабного вторгнення їхня кількість збільшилась, а тактика щоразу змінюється.

У мережі можна зустріти різни приклади російських вкидів: «криве» інсценування, поганий фотошоп, фейкові репортажі та сайти, які видають за публікації західних медіа. Паралельно з цим російська пропаганда опановує штучний інтелект та підроблює новини, де військових виставляють головними винуватцями у будь-якій ситуації. Так, підробки все ще неідеальні, проте подекуди мають кращу якість.

Далі — про останні російські підробки та як з ними боротися.

Шедеври російського кінематографа

Російська пропаганда регулярно створює постановочні відео. Наприклад, росіяни опублікували ролик, де начебто мобілізований б’є військового ТЦК, якого також відправили на передову. Або ж розповідають, що буцімто військовий побив поліціянта у Харкові.

Інсценовані відео

Для деяких відео росіяни використовують одних й тих самих «акторів». Наприклад, опублікували ролик, де начебто військові ТЦК опускають жінку у колодязь. Причиною такого «покарання» буцімто став напад жінки на військового — мовляв, вона захищала свого чоловіка. Через певний час з’явилося відео, де «українські військові» розстрілюють жінку. За «сюжетом» вона продала бійцям ЗСУ неякісний алкоголь, через що ті померли. Жінки між собою на цих двох відео схожі: мають однаковий голос та подібний одяг.

Інсценовані відео з однаковою «акторкою»

Як розпізнати постановку?

- «Феноменальна» акторська гра (часом одних і тих самих акторів).

- Їх переважно видає акцент. Хоча росіяни покращують українську, але вона далека до ідеальної.

- Ненормативний одяг, а розпізнавальні знаки хибні або ж відсутні.

- Бракує важливих деталей: адрес, імен, дат тощо, що дивно, бо за «легендою» ці відео знімають для розголосу.

- Відео поширюють сумнівні ресурси. Росіяни використовують тези «отримали відео з телефону полоненого/загиблого бійця ЗСУ» або «побачили в українському тіктоці». Для останнього самі ж росіяни створюють акаунти.

- Дивні ракурси фільмування: під час зйомки найважливіші деталі (обличчя людей чи моменти пострілів) не потрапляють у кадр.

Фотошоп та російська дезінформація

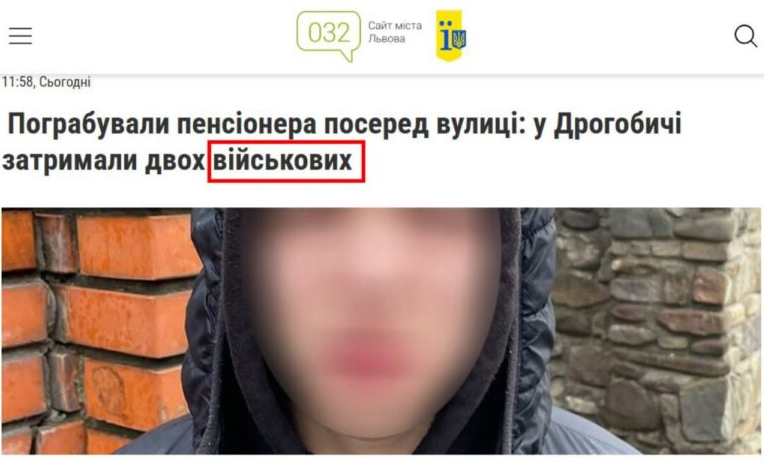

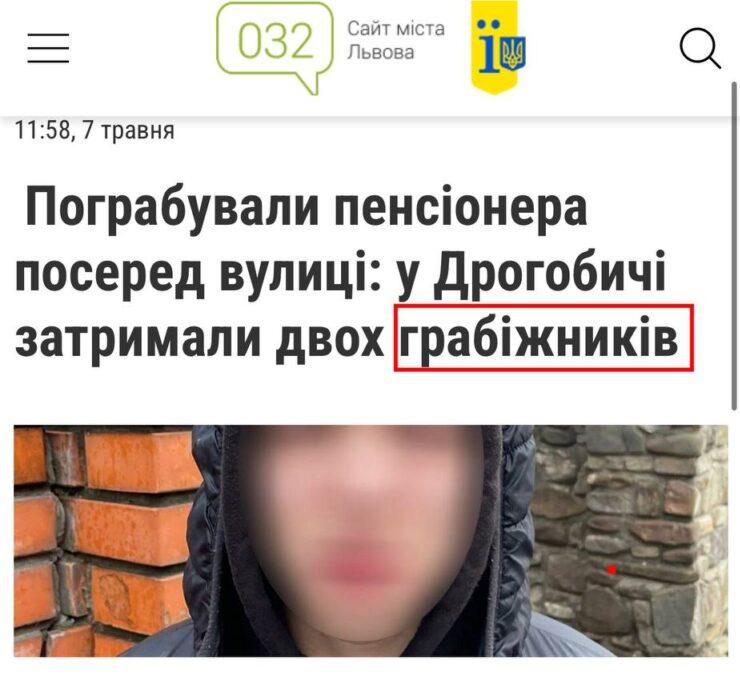

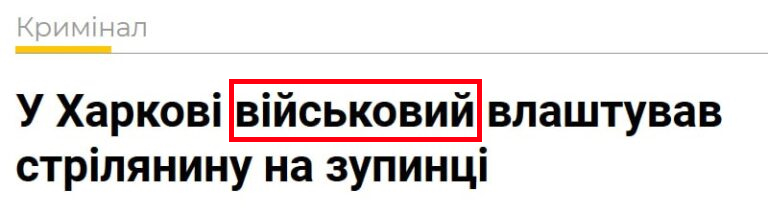

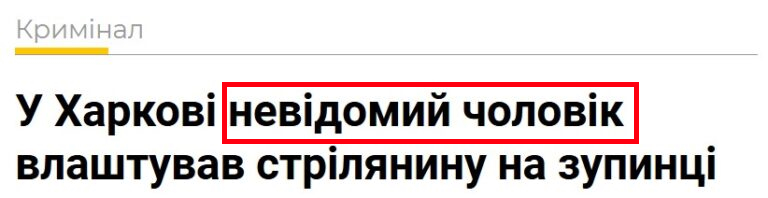

Крім відеопостанов, російська пропаганда також поширює відредаговані скриншоти, на яких приписує українським захисникам грабіж, вбивство чи будь-які інші злочини. Для їх створення у справжні статті українських медіа про злочини додають текст про військових. Проте в оригіналі жодних згадок про причетність зловмисників до війська немає.

Зверху — фейкова новина. Знизу — оригінальна стаття

Зверху — фейкова новина. Знизу — оригінальна стаття

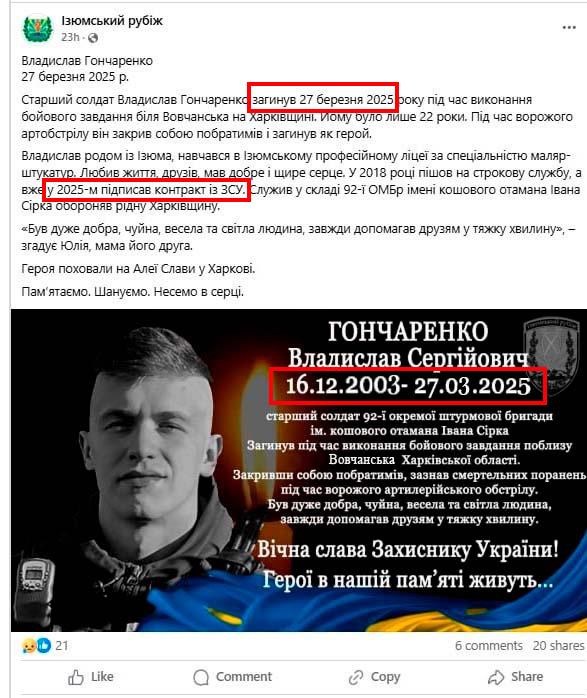

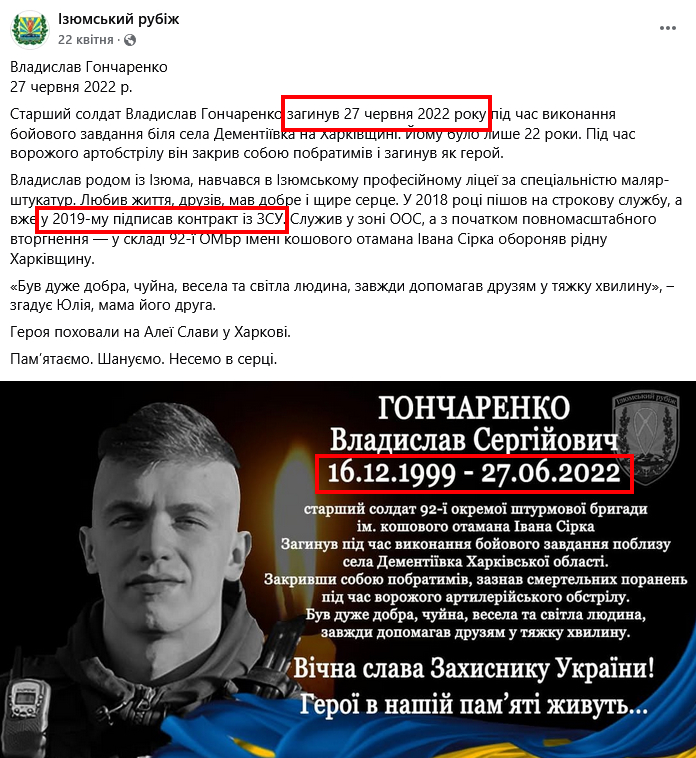

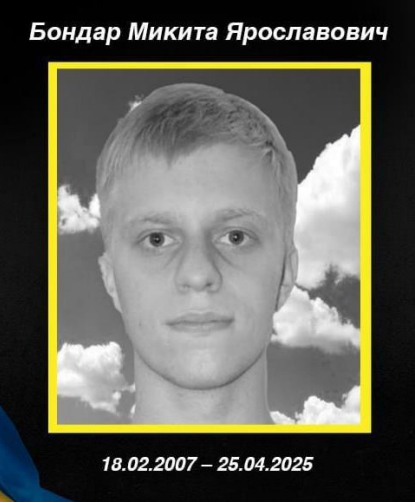

Окремий напрям фотопідробок — відредаговані некрологи. Особливо росіяни роблять акцент на дискредитації «Контракту 18-24». Росіяни брешуть про смерть військових, які підписали контракт, ще до моменту закінчення їхнього навчання.

Подібні фейки росіяни поширили про смерть Олександра Самойловича та Владислава Гончаренка, які нібито погодились на «Контракт 18-24». Ці військові, на жаль, справді загинули, проте не мали стосунку до програми. Дописи про їхню смерть відредагували.

Зверху — фейковий скриншот. Знизу — скриншот оригінального допису

Ще один приклад: пропагандисти для створення фейкового некролога вигадали ім’я 18-річного військового (Микита Бондар) та використали фото призера олімпіад з інформатики.

За допомогою сервісу розпізнавання облич PimEyes ми встановили, що на фото не Микита Бондар, а Денис Терещенко. Хлопець неодноразово брав участь в олімпіадах з інформатики. Фото, яке використали для фейку про загибель, зробили у вересні 2024 року. Тоді хлопець здобув срібну медаль у Міжнародній олімпіаді з інформатики в Александрії, Єгипет. У вересні 2024 року Терещенко був у 11 класі, відтак його навчання мало тривати до травня 2025 року. Тобто він не міг долучитися до армії, адже перебував у школі.

Зверху — фото з фейкового допису; знизу — фото Дениса Терещенка

Як розпізнати фотофейки?

- Знайти та переглянути оригінальні публікації про подію (новину у медіа чи пост у соцмережах).

- Додатково перевірити інформацію в якісних всеукраїнських чи регіональних медіа.

- Здійснити зворотний пошук фото, щоб знайти оригінальну світлину та інформацію про неї.

Штучний інтелект на службі російської пропаганди

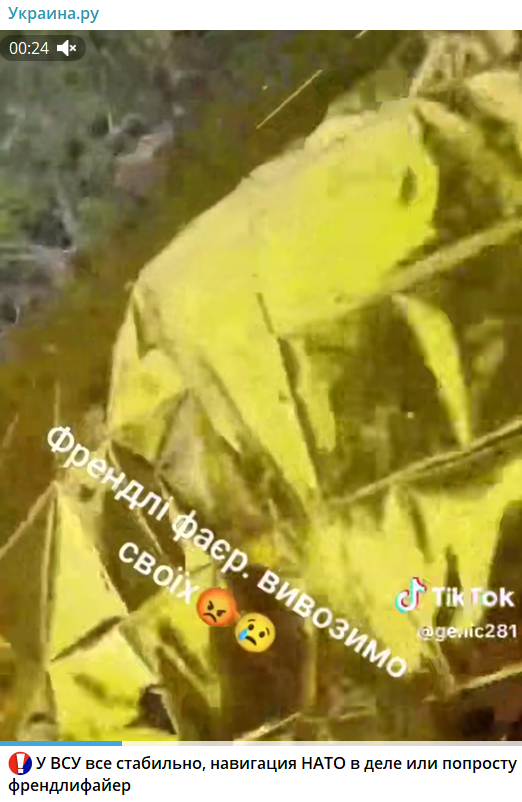

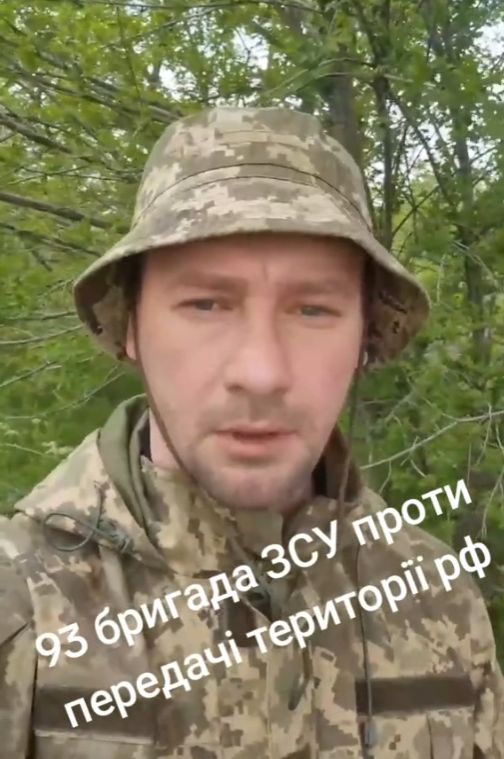

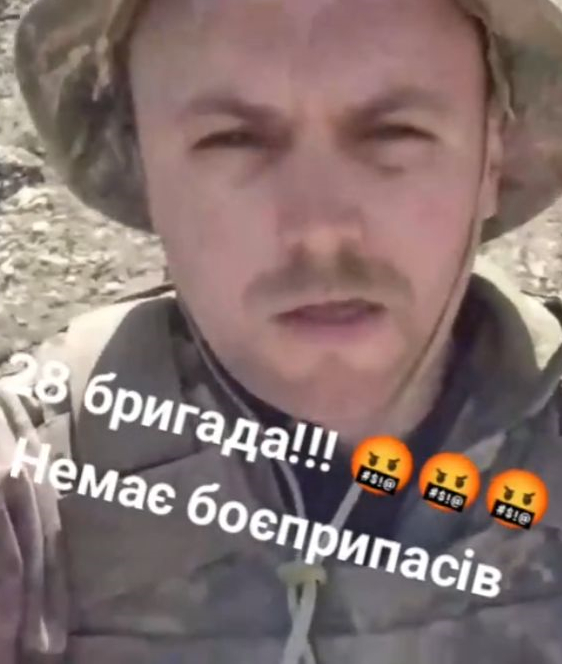

Також для створення фейкових відео чи фото російська пропаганда використовує штучний інтелект. До прикладу, росіяни поширювали відео, де начебто український військовий розповідав про «дружній вогонь» через відсутність координації між військовими. Або ж як військовий начебто говорить про похід у СЗЧ через втрати та погане керівництво. Для їхнього створення росіяни підмінювали обличчя та генерували звукові доріжки.

Фейки, де використали штучний інтелект

Також є приклади, коли один й той самий «військовий» служить у різних підрозділах та має різний голос.

Відео, де використали ШІ

За допомогою ШІ створюють не лише фейкові відео про військових, але й фото. У мережі неодноразово поширювали згенеровані світлини, де закликали помолитись за військових чи привітати їх зі святом. Але не весь ШІ-контент такий «невинний» — згодом у постах можуть зловживати довірою до військових та вкидати «зраду».

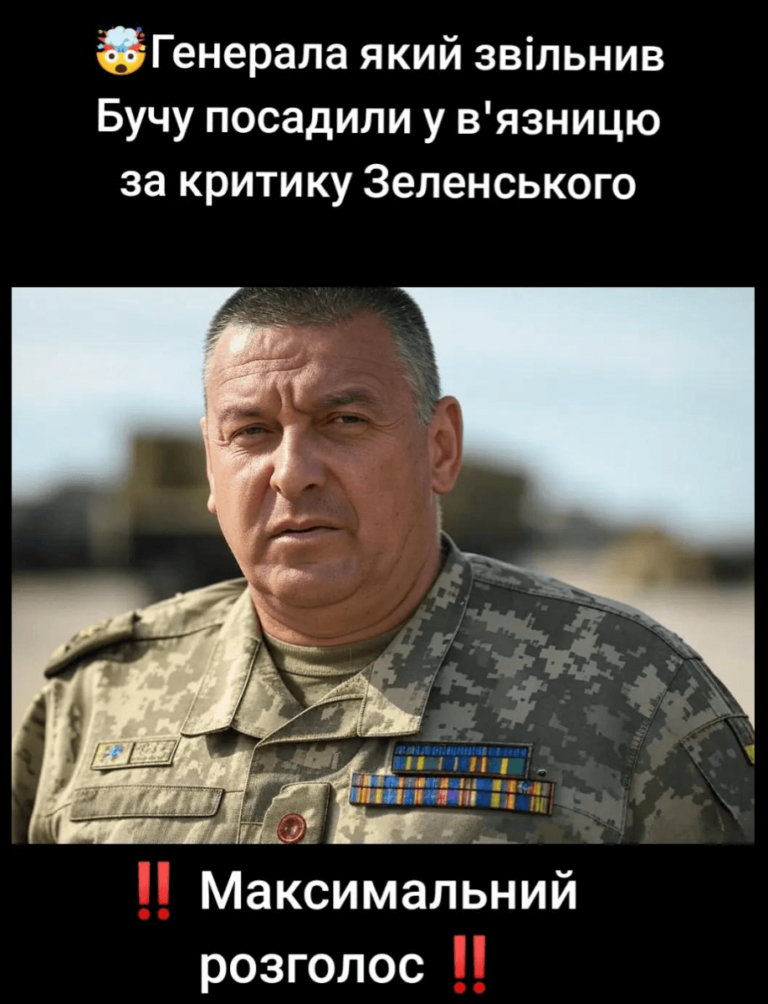

Наприклад, у мережі поширювали фото буцімто генерала, який «звільнив Бучу», а потім отримав тюремний термін за критику Володимира Зеленського. Хоча насправді зображення військового згенерували за допомогою ШІ.

Фото, згенероване ШІ

Як розпізнати діпфейки?

- Розбіжність у жестикуляції: обличчя виглядає неприродно, рухи головою обірвані, а міміка не збігається зі словами

- Візуальні дефекти: «глянцева» шкіра, зайві пальці, розмитий фон або ж його елементи виглядають дивно та не відповідають контексту.

- «Ідеальність фото»: світлина має наче студійне освітлення, ідеальну симетрію, позу та кут зору. Шкіра має нереалістичну однорідну і чітку текстуру, позбавлену людських недоліків.

- Неточності в одязі, розпізнавальних знаках тощо.

- Нелогічне розташування об’єктів (у двох фото на одну тематику будівля виглядає по-різному), нереалістичне освітлення або порушення фізичних законів.

- Звукові неточності чи помилки (відсутність звуків на фоні, їхня неприродність чи невідповідність).

- Неякісне джерело, яке поширює фейк (притаманно для багатьох фейків).

- Можна скористатись інструментами для виявлення ШІ (Hive Moderation, Deepware Scanner чи DeepFake-o-meter). Так, вони не дають 100% результату, проте у комплексі з іншими методами допоможуть виявити фейк.

Російська пропаганда невпинно вдосконалює свої методи дискредитації українських військових, комбінуючи старі інструменти, як-от постановочні відео та фотошоп, із сучасними технологіями, зокрема штучним інтелектом. Від грубих інсценувань до діпфейків — кожен із цих засобів спрямований на підрив довіри до Сил оборони, які залишаються ключовою опорою суспільства. Проте численні ознаки фальсифікацій — від акторських промахів до технічних недоліків ШІ — дозволяють викривати ці фейки. Якщо ви помітили сумнівну інформацію у мережі, скористайтесь нашими порадами з перевірки.

Фото: depositphotos.com/ua

Застереження

Автор не є співробітником, не консультує, не володіє акціями та не отримує фінансування від жодної компанії чи організації, яка б мала користь від цієї статті, а також жодним чином з ними не пов’язаний